A.I Now 2020

Matinée grand public

Maison des Entreprises Metz Technopôle

Samedi 8 février 2020

« A.I now « est un événement conçu par Frédéric Schnur en 2019 pour revenir de façon annuelle, au milieu du 1er semestre, pour faire un point régulier sur l’état de l’art, les tendances, les pistes de réflexion, et aussi des outils concrets relatifs à l’Intelligence Artificielle, à destination tant des professionnels que du grand public.

Le Secrétaire général de l’IGR était présent lors de la matinée ouverte au grand public du samedi 8 février 2020

Ah oui d’accord ! Mais c’est quoi une IA ? Manuel Masiello Consultant en IA (cabinet Deep42)

L’intelligence artificielle ou encore IA, est un ensemble d’algorithmes conférant à une machine des capacités d’analyse et de décision lui permettant de s’adapter intelligemment aux situations en faisant des prédictions à partir de données déjà acquises.

L’intelligence artificielle associe les logiciels à des composants physiques (ou « hardware ») qui peuvent être des capteurs, des interfaces pour l’utilisateur…

L’intelligence artificielle permet :

- D’analyser des textes : qu’ils soient oraux ou écrits, l’intelligence artificielle arrive de mieux en mieux à comprendre et utiliser le langage pour répondre automatiquement à des requêtes variées. Aujourd’hui, elle est utilisée, par exemple, pour gérer les relations clients, sur Internet ou par téléphone. Les agents conversationnels ou chatboten anglais sont des systèmes intelligents qui arrivent à entretenir une conversation en langage naturel. Ils se basent sur différentes briques technologiques : reconnaissance de texte, de la parole, d’expressions du visage…

- De modéliser des connaissances pour aider à la prise de décisions : l’intelligence artificielle permet de coder un ensemble de connaissances, de reproduire un raisonnement type et d’utiliser ces informations pour prendre des décisions. Par exemple, il est aujourd’hui possible, à partir de données multiples et complexes, d’aider les médecins à proposer des traitements personnalisés du cancer de la prostate.

- De produire des connaissances grâce au « machine learning» ou apprentissage automatique : grâce à l’intelligence artificielle, la machine devient capable de repérer des tendances ou des corrélations dans un très grand volume de données, en adaptant ses analyses et ses comportements et ainsi de créer ses propres connaissances en fonction de l’expérience accumulée. Cela permet de proposer des prédictions très fines sur la consommation d’énergie, l’évolution du comportement d’une machine ou d’un bâtiment. Les règles prédictives qui en sont tirées ne sont que le résultat de ce qui a déjà eu lieu ; ce ne sont pas des lois générales.

- D’analyser des images ou des scènes en temps réel : reconnaître des défauts de fabrication ou détecter des visages. Par exemple, certaines usines ont des robots qui détectent en temps réel les problèmes techniques, défauts et corrigent ou arrêtent la production. Pour parvenir à analyser une très grande quantité de données visuelles en simultané, les chercheurs développent des logiciels à base de réseaux de neurones profonds, qui permettent aux ordinateurs d’acquérir des capacités d’apprentissage (deep learning).

- De réaliser des actions : par exemple, l’intelligence artificielle permet d’imiter et reproduire à la perfection certains gestes humains comme celui d’administrer un vaccin via une main robotisée.

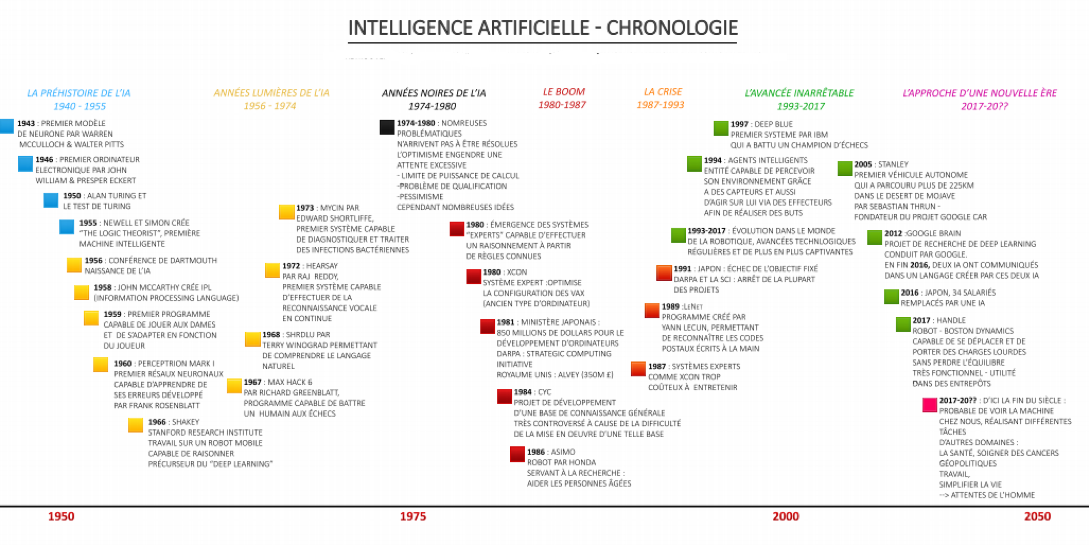

La nouvelle ère de développement depuis 2017, s’appuie sur la puissance de calcul des ordinateurs, les big data (importance des GAFA) et le deep learning ou apprentissage profond , c’est un type d’intelligence artificielle dérivé du machine learning (apprentissage automatique) où la machine est capable d’apprendre par elle-même, contrairement à la programmation où elle se contente d’exécuter à la lettre des règles prédéterminées).

En conclusion : on ne comprend pas vraiment comment fonctionne l’IA et n’oublions pas qu’ à la différence de l’homme, l’IA est pour le moment mono tâche.

OLKi l’IA du langage Aurore Coince chargée de projet et de partenariat Université de Lorraine

Lancé en mars 2019, OLKi (Open Language and Knowledge for Citizens) est un projet IMPACT Lorraine Université d’Excellence ancré dans le défi portant sur l’ingénierie des langues et des connaissances. Interdisciplinaire, le projet mêle l’informatique et les mathématiques aux sciences humaines et sociales. Il est coordonné par Christophe Cerisara, chargé de recherche CNRS au Loria, responsable de l’équipe Synalp et Aurore Coince, cheffe de projet.

La fuite des données : une problématique sociétale et scientifique

En mai 2018, la société de marketing politique et commercial Cambridge Analytica a annoncé la cessation de ses activités. La cause de cette faillite : un scandale international l’accusant d’avoir utilisé les données personnelles de quelques 87 millions d’utilisateurs de Facebook à des fins politiques. La recrudescence de ce type de scandale entraîne une méfiance et une incompréhension de la part des citoyens vis-à-vis de l’intelligence artificielle (IA).

La problématique de protection des données touche également les scientifiques : les méthodes d’apprentissage profond (deep learning), omniprésentes aujourd’hui dans les domaines applicatifs de l’IA perdent toute leur valeur si elles ne sont pas nourries en continue par de grandes quantités de données. Les données sont ainsi souvent comparées au pétrole en terme d’importance stratégique. Or, la très grande majorité de ces richesses sortent de nos frontières et sont contrôlées par des entreprises privées, ce qui limite leur utilisation par les scientifiques français et européens.

Alors, comment garder le contrôle de ces masses de données, et comment les extraire sans porter atteinte à la vie privée des citoyens qui en sont à l’origine ?

Le projet OLKi a pour mission de concilier ces deux problématiques : concevoir de nouveaux algorithmes d’apprentissage automatique dédiés à l’extraction des connaissances à partir de données langagières, et réfléchir et proposer des solutions qui garantissent un contrôle équitable, ouvert et partagé des données ainsi qu’une utilisation de ces données qui respecte le citoyen et sa vie privée.

Vers un changement de paradigme communicationnel

Les données sur les réseaux sociaux constituent un potentiel énorme pour les chercheurs en intelligence artificielle. Seulement, peut-on y accéder ? Qui en a réellement le contrôle ? Le projet OLKi propose d’adapter nos moyens de communication à nos besoins et d’œuvrer à la réappropriation du contrôle des données par les chercheurs et les citoyens.

Une plateforme alternative issue d’un mouvement citoyen de grande ampleur

Le cœur du projet est de proposer des alternatives et de s’affranchir des réseaux habituels en développant une plateforme.

Des initiatives institutionnelles et citoyennes existent déjà, comme Academic Torrents, P2P, Ortolang, Datagouv… et le Fediverse.

Ce dernier réseau, développé surtout en Europe et au Japon, déjà riche de 2,5 millions d’utilisateurs, est une fédération de serveurs interconnectés, construite autour de logiciels libres.

La plateforme développée par le projet OLKi prévoit de s’interconnecter aux nœuds du Fediverse et d’ajouter aux ressources qui y existent déjà (musique, blogs, vidéos…) une dimension recherche et connaissances scientifiques. Cette plateforme ambitionne de fluidifier la communication entre les acteurs –chercheurs, fournisseurs de services et citoyens, hébergera et diffusera des ressources scientifiques liées au langage et aux connaissances qui en sont extraites.

À terme, au-delà des progrès en termes de contrôle, d’éthique, d’ouverture, de transparence et de respect de la vie privée, la plateforme résoudra des problèmes de nombreuses plateformes scientifiques actuelles, dont la maintenance à long terme, le passage à l’échelle, la réduction des coûts, le contrôle des fournisseurs de données et l’interaction entre recherche et citoyens.

OLKi : un projet interdisciplinaire

OLKi est porté par cinq laboratoires : le Loria pour les aspects liés à l’informatique et à l’intelligence artificielle, l’IECL pour la formalisation mathématique, notamment concernant l’apprentissage automatique, l’ATILF pour les notions de linguistique, les Archives Henri Poincaré pour les questions épistémologiques et éthiques, et le CREM, pour les questions d’usage des médias et des réseaux sociaux.

En interconnectant ces différentes disciplines, les membres du projet OLKi vont mener des travaux tels que la production de ressources sur l’apprentissage des langues, la détection de discours haineux sur les réseaux sociaux, l’étude des dynamiques de groupe à grande échelle, l’analyse des discours et des corpus…

Etat des lieux des usages sociaux de l’IA Olivier Buchheit Ingénieur généraliste en mécanique et docteur en physique du solide fondateur de l’entreprise Sonopraxis

Notre époque est caractérisée par une explosion d’innovations technologiques et scientifiques catalysées par le digital. La vaste interconnexion des systèmes cyber physiques est maintenant bien au centre de notre développement socio- économique ; et la Data, véritable Pétrole Numérique, alimente à grands flots l’ensemble du système. Dans ce contexte, le Transhumanisme pousse cette interconnexion à son paroxysme : l’être humain-machine, comme assemblage partiel d’éléments technologiques repoussant singulièrement les limites biologiques, physiques et cognitives de l’individu, en lui ajoutant toujours plus de fonctionnalité dans le Grand Tout Connecté.

L’IA, au-delà de la mythologie que certains entretiennent, relève en réalité d’un ultra empirisme qui peut se résumer à « apprendre sans comprendre », « décider sans comprendre » pour la machine et « exploiter sans pouvoir expliquer » pour l’homme.

Gardons aussi toujours à l’esprit que si l’Intelligence artificielle exécute à une extraordinaire vitesse des tâches précises, bien définies (le but de toute machine), l’intelligence humaine est multidimensionnelle, adaptative et autonome.

Comment articuler SAVOIR, PUISSANCE et RESPONSABILITE ?

Les principaux points de vigilance :

- la reconnaissance faciale (le permis de bonne conduite citoyenne en Chine) ;

- les données relatives à la santé (quid de leur utilisation par des assurances ?) ;

- la lecture des pensées (en 2017, une équipe de neuro-ingénieurs américains a mis au point une intelligence artificiellecapable de convertir le signal électrique du cerveau en parole) ;

- la limite écologique.

|

Une étude de GreenIt, Empreinte environnementale du numérique mondial, portant sur son empreinte actuelle, mais aussi sur son évolution entre 2010 et 2025, est parue en 2019et en donne des chiffres impressionnants :. En effet, alors qu’on décompte actuellement quelque 34 milliards d’équipements pour 4,1 milliards d’utilisateurs, l’empreinte environnementale ne peut être négligeable ! Le numérique représente environ 6 800 TWh d’énergie primaire, 1 400 millions de tonnes de gaz à effet de serre et 7,8 millions de m3 d’eau douce. Soit encore 4,2 % de l’énergie primaire mondiale, 3,8 % des gaz à effet de serre et 0,2 % de la consommation d’eau. Si l’on rapporte cela au quotidien, en matière de gaz à effet de serre, c’est l’équivalent de 1,5 milliard de salariés français allant travailler pendant 1 an, en eau de 242 milliards de packs d’eau minérale (de 9 litres) et en électricité 82 millions de radiateurs électriques (1000 Watts) allumés en permanence… Cet univers numérique grossit entre 2010 et 2025 dans des proportions importantes : il est multiplié par un facteur allant de 3 à 5. Son empreinte numérique s’en trouvera multipliée par 2 ou par 3, passant ainsi de 2,5 % de l’empreinte de l’humanité à un peu moins de 6 %. Son augmentation reste bien plus rapide que la majorité des autres secteurs de l’économie. |

La cyber sécurité est un enjeu essentiel à l’échelle mondiale et nécessite une conscience collective et une gouvernance à ce niveau.

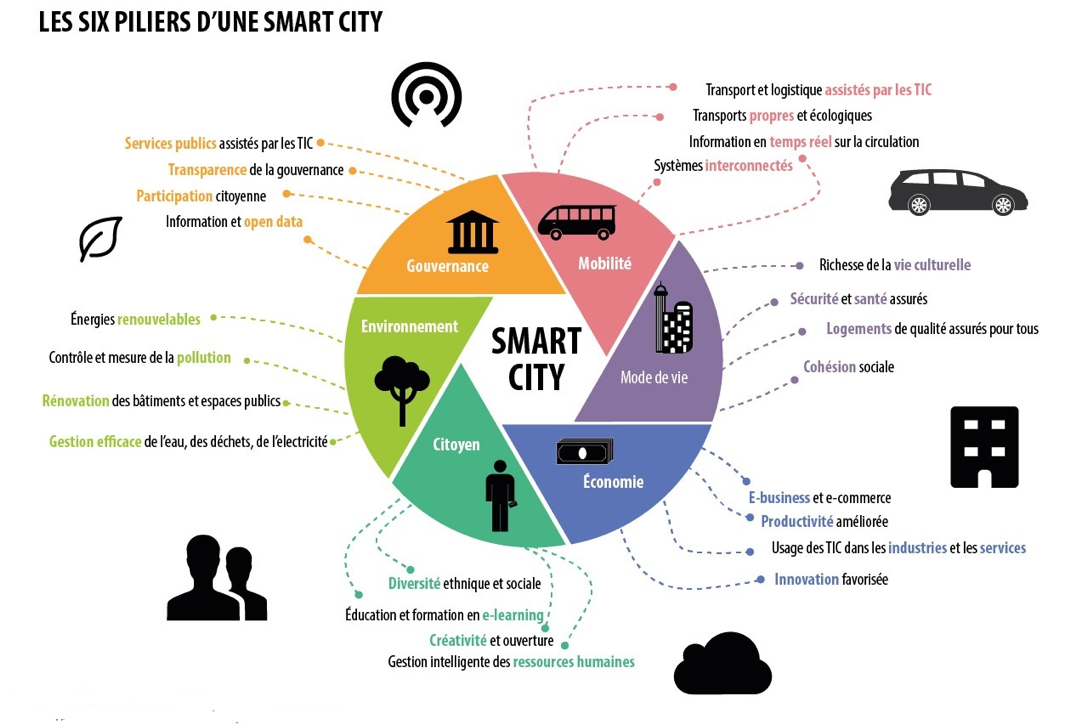

La ville intelligente, quel apport pour le citoyen ? Laurent Casagrande, géographe et développeur numérique cofondateur de l’entreprise Greenberry

Le concept de ville intelligente, ou Smart City est aujourd’hui largement démocratisé et les chantiers de plus en plus nombreux. A l’heure de l’ultra connexion et des objets communicants, quels sont les enjeux d’aujourd’hui qui ouvrent les perspectives pour demain ?

Les principes éthiques qui doivent prévaloir :

- Autonomie de l’humain / prise de décision ;

- Robustesse technique et sécurité ;

- Confidentialité et gouvernance publique de la donnée ;

- Transparence ;

- Diversité, non discrimination et équité ;

- Bien être social et environnemental ;

- Responsabilité.

Les enjeux essentiels pour les collectivités :

- Identifier et comprendre les enjeux ;

- Récupérer les données ;

- Exploiter les données (en veillant à développer préalablement une culture digitale tant chez les élus que les techniciens) ;

- Intégrer une réflexion partagée ;

- Mettre en place une gouvernance et une gestion interne des données.

![]()

Trackbacks (rétroliens) & Pingbacks

[…] Ai_Now 2020: 8 février 2020 Maisons des Entreprises Metz Technopôle. https://institut-gr.eu/2020/02/08/a-i-now-2020/ […]

[…] Ai_Now 2020: 8 février 2020 Maisons des Entreprises Metz Technopôle . https://institut-gr.eu/2020/02/08/a-i-now-2020/ […]

Les commentaires sont désactivés.